HBM Là Gì? Ứng Dụng Và Lý Do HBM Đẩy Giá RAM, SSD Tăng Mạnh 2025

Tìm hiểu HBM là gì, công nghệ bộ nhớ băng thông cao được dùng trong AI, GPU và HPC. Vì sao HBM lại khiến giá RAM và SSD tăng vọt trong nửa cuối năm 2025?

HBM – tương lai của trí tuệ nhân tạo, nhưng cũng là nguyên nhân khiến giá linh kiện “leo thang” toàn cầu

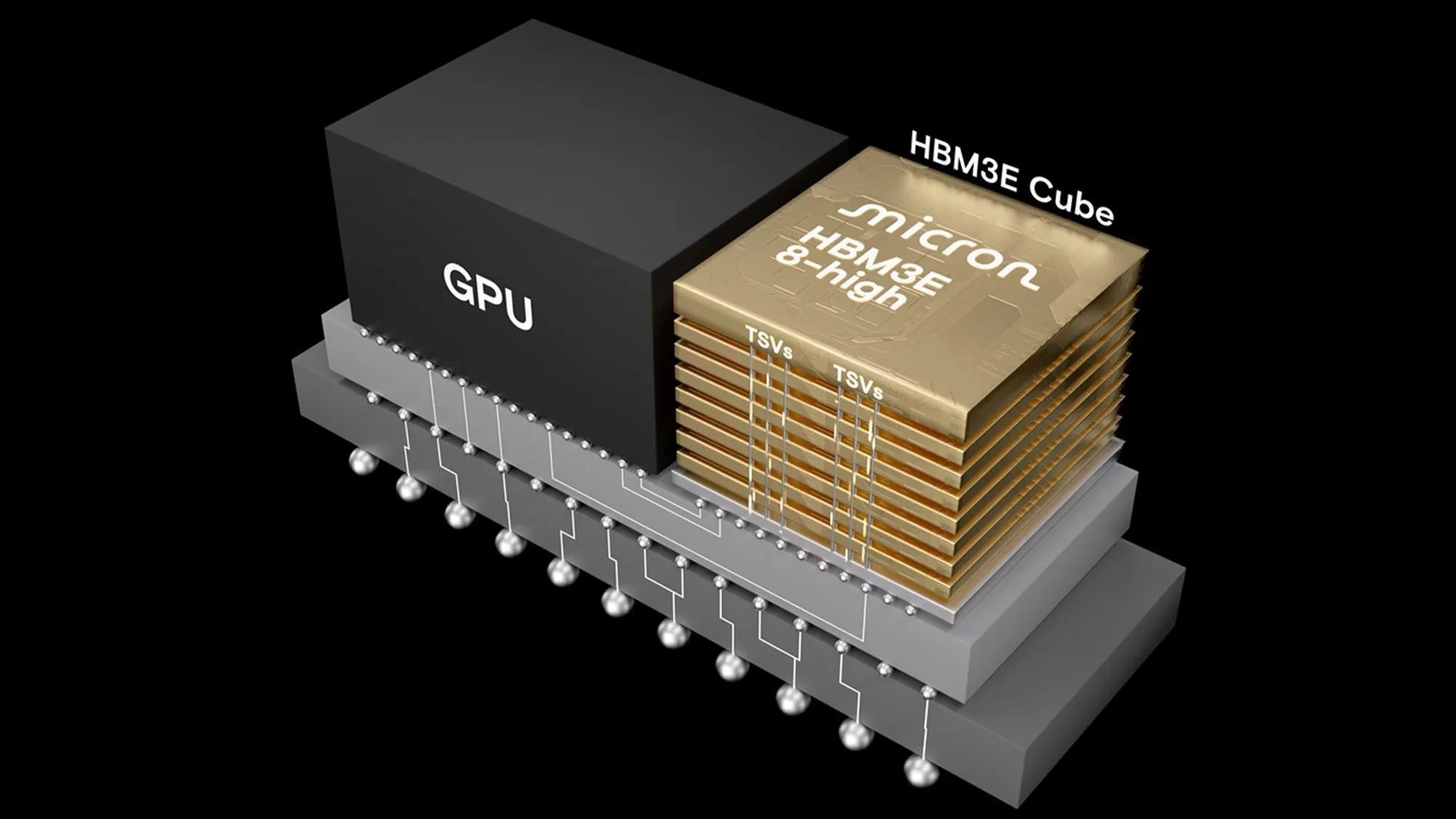

HBM (High Bandwidth Memory) là bộ nhớ băng thông cao, được phát triển nhằm đạt tốc độ truyền dữ liệu vượt xa RAM truyền thống như DDR5 hoặc GDDR6.

Khác với thiết kế phẳng của RAM thông thường, HBM được xếp chồng theo chiều dọc (3D stacked memory) — nhiều lớp DRAM được nối với nhau bằng TSV (Through-Silicon Via) để tăng mật độ và giảm độ trễ truy cập dữ liệu.

Với thiết kế này, HBM có thể đạt băng thông lên đến hàng terabyte mỗi giây, trong khi tiêu thụ điện năng ít hơn đáng kể so với GDDR hay DDR. Điều này khiến HBM trở thành lựa chọn lý tưởng cho các hệ thống cần xử lý dữ liệu khổng lồ và tốc độ cao.

HBM không được dùng trong máy tính phổ thông mà chủ yếu xuất hiện trong các lĩnh vực yêu cầu hiệu năng cực cao, bao gồm:

- AI & Machine Learning: Dùng trong GPU và accelerator (như NVIDIA H100, AMD MI300, hay chip AI của Intel) để xử lý mô hình ngôn ngữ và dữ liệu huấn luyện khổng lồ.

- HPC (High-Performance Computing): Các siêu máy tính cần khả năng truyền dữ liệu nhanh giữa CPU/GPU và bộ nhớ.

- Đồ họa cao cấp & Workstation: Một số card đồ họa chuyên nghiệp (như Radeon Pro hay NVIDIA Quadro) dùng HBM để tối ưu tốc độ render.

- Thiết bị viễn thông và trung tâm dữ liệu (Data Center): Giúp giảm độ trễ và tiết kiệm năng lượng cho hệ thống xử lý dữ liệu khổng lồ.

Các phiên bản HBM cho đến nay

| Phiên bản | Năm ra mắt | Băng thông tối đa | Dung lượng mỗi stack | Ứng dụng |

| HBM1 | 2015 | ~128 GB/s | 1–4 GB | Dùng trong AMD Fury X |

| HBM2 | 2016 | ~256 GB/s | 8 GB | Xuất hiện trên NVIDIA Tesla V100 |

| HBM2e | 2020 | ~460 GB/s | 16 GB | Cải thiện hiệu suất cho AI và HPC |

| HBM3 | 2022 | ~819 GB/s | 24 GB | Được dùng trong NVIDIA H100 |

| HBM3e | 2024–2025 | ~1.2 TB/s | 36 GB | Chuẩn mới, tối ưu cho AI thế hệ mới (H200, MI325X, v.v.) |

Tại sao HBM lại ảnh hưởng đến thị trường RAM và SSD?

Nửa cuối năm 2025, nhu cầu HBM tăng bùng nổ do làn sóng AI. Các hãng như NVIDIA, AMD, và cả các công ty AI như OpenAI, Google DeepMind… đều cần lượng lớn HBM để sản xuất GPU AI.

Điều này tạo ra sự khan hiếm nguồn cung DRAM toàn cầu, vì:

- Các nhà sản xuất như SK Hynix, Samsung, Micron phải ưu tiên sản xuất HBM, giảm công suất cho DRAM thông thường (DDR5).

- Giá chip nhớ DRAM tăng → kéo theo giá RAM PC, laptop và SSD (vốn dùng NAND/DRAM làm cache) tăng theo.

- Tình trạng thiếu hụt nguồn cung khiến thị trường linh kiện PC bị xáo trộn mạnh, nhất là phân khúc gaming và workstation.

Theo nhiều báo cáo, giá DRAM trong nửa cuối 2025 đã tăng 25–40%, và SSD cao cấp cũng tăng khoảng 20%, do hiệu ứng dây chuyền từ cơn khát HBM trong lĩnh vực AI.

HBM là bước tiến đột phá trong công nghệ bộ nhớ, giúp mở ra kỷ nguyên AI và siêu máy tính. Tuy nhiên, chính nhu cầu khổng lồ từ các trung tâm dữ liệu và chip AI đã khiến thị trường RAM và SSD dân dụng “dậy sóng” trong năm 2025.

Nếu xu hướng này tiếp tục, người dùng phổ thông sẽ phải chấp nhận giá linh kiện cao hơn, ít nhất cho đến khi năng lực sản xuất HBM và DRAM được mở rộng trong năm 2026–2027.