Tin Tức Công Nghệ, Kiến Thức, Đánh Giá Review Thiết Bị Tin Học

Cảnh báo Deepfake 2025: Mất sạch tiền chỉ sau 1 phút gọi Video – Cách nhận biết ngay lập tức

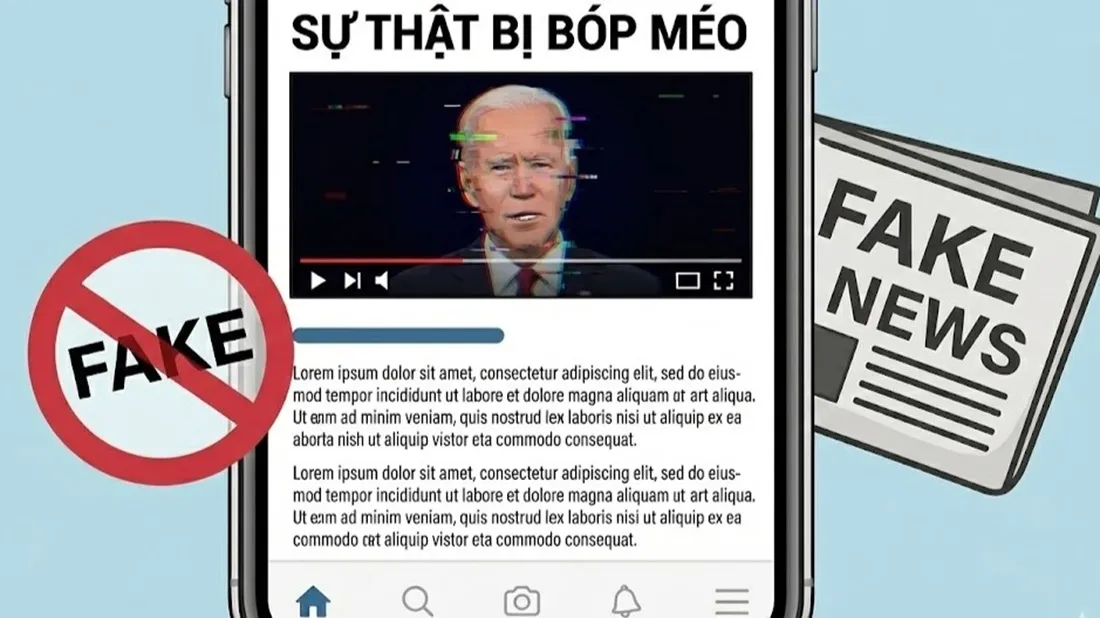

Đã qua rồi cái thời kẻ lừa đảo chỉ nhắn tin "Anh ơi nạp thẻ giúp em". Năm 2025, tội phạm công nghệ cao đã nâng cấp lên một tầm cao mới đáng sợ hơn: Deepfake Video Call. Chỉ cần 1 phút lơ là khi nhìn thấy khuôn mặt "người thân" gọi điện qua video, toàn bộ tiền trong tài khoản của bạn có thể "bốc hơi". Tại sao công nghệ này lại nguy hiểm đến vậy và làm thế nào để nhận biết thật - giả trong tích tắc? Bài viết này sẽ là tấm lá chắn bảo vệ bạn.

Deepfake 2025: Khi "Mắt thấy tai nghe" cũng không còn là sự thật

Năm 2025, sự bùng nổ của các công cụ AI tạo sinh (Generative AI) giá rẻ đã giúp kẻ xấu dễ dàng tạo ra các video giả mạo với độ chân thực lên tới 90%.

Thu thập dữ liệu: Chúng quét hình ảnh, video, giọng nói của bạn hoặc người thân công khai trên Facebook, TikTok, Instagram.

Xử lý thời gian thực: AI có thể ghép khuôn mặt nạn nhân vào video có sẵn và thậm chí nhép miệng (lip-sync) theo văn bản mà kẻ lừa đảo gõ vào.

Cảnh báo: Mục tiêu của chúng không chỉ là người lớn tuổi mà cả những người trẻ rành công nghệ, nhân viên văn phòng và kế toán doanh nghiệp.

3 Kịch bản lừa đảo "thao túng tâm lý" phổ biến nhất

Kẻ gian thường đánh vào tâm lý hoảng loạn hoặc sự tin tưởng tuyệt đối để khiến bạn không kịp suy nghĩ:

Kịch bản "Cấp cứu/Tai nạn": Giả danh con cái, người thân đang du học hoặc đi làm xa gọi về báo tin gặp tai nạn, cần chuyển tiền viện phí gấp.

Kịch bản "Sếp tổng/Đối tác": Giả danh CEO hoặc lãnh đạo gọi video cho kế toán yêu cầu chuyển tiền thanh toán hợp đồng gấp vào tài khoản lạ.

Kịch bản "Cơ quan chức năng": Giả danh Công an mặc sắc phục, gọi video yêu cầu xác minh tài sản liên quan đến vụ án ma túy/rửa tiền.

5 Dấu hiệu "vạch trần" cuộc gọi Deepfake ngay lập tức

Dù công nghệ 2025 đã rất tinh vi, nhưng Deepfake thời gian thực vẫn có những "điểm chết" về kỹ thuật mà mắt thường có thể nhận ra nếu để ý kỹ:

1. Khuôn mặt thiếu cảm xúc và ít chớp mắt

AI thường gặp khó khăn trong việc tái tạo các chuyển động vi mô (micro-expressions). Khuôn mặt trong video thường cứng đờ, ít biểu cảm hoặc chớp mắt không tự nhiên (quá nhanh hoặc không bao giờ chớp mắt).

2. Lỗi kỹ thuật ở vùng biên (Glitch)

Hãy nhìn kỹ vào các vùng tiếp giáp như viền khuôn mặt, cổ, mái tóc hoặc vành tai. Khi nhân vật quay đầu nhẹ, bạn sẽ thấy hình ảnh bị nhòe, răng cưa hoặc bóng mờ chồng lên nhau.

3. Độ trễ giữa âm thanh và hình ảnh (Lip-sync lỗi)

Do phải xử lý dữ liệu lớn, video Deepfake thường có độ trễ (delay). Tiếng nói phát ra có thể không khớp với khẩu hình miệng, hoặc giọng nói nghe có vẻ "đều đều", thiếu ngữ điệu cảm xúc tự nhiên (giọng robot).

4. Chất lượng cuộc gọi luôn "chập chờn"

Đây là chiêu trò cố ý! Kẻ gian thường làm giảm độ phân giải video hoặc giả vờ sóng yếu, hình ảnh bị vỡ hạt (pixelated) để che giấu các lỗi đồ họa của AI.

Nếu người gọi nói: "Sóng yếu quá, chuyển tiền gấp đi rồi nói sau", 99% đó là lừa đảo.

5. Yêu cầu chuyển tiền vào tài khoản LẠ

Dù người gọi là "bố mẹ" hay "sếp", nhưng số tài khoản nhận tiền lại là tên một người lạ hoắc. Đây là dấu hiệu chốt hạ để bạn ngắt máy ngay lập tức.

Quy trình "3 Bước Vàng" để bảo vệ tài khoản ngân hàng

Nếu nhận được cuộc gọi video có dấu hiệu nghi ngờ, hãy bình tĩnh thực hiện quy trình sau:

Bước 1: Ngắt kết nối ngay lập tức. Không duy trì cuộc gọi để tránh bị kẻ xấu ghi âm/ghi hình ngược lại bạn.

Bước 2: Kiểm tra chéo (Cross-check). Gọi lại cho người đó bằng số điện thoại thông thường (gọi thoại qua sim), tuyệt đối không gọi lại qua ứng dụng chat (Zalo/Messenger) vì tài khoản đó có thể đã bị hack.

Bước 3: Đặt "câu hỏi khắc tinh". Hỏi những thông tin cá nhân mà AI không thể biết.

Ví dụ: "Hồi xưa con nuôi con chó tên gì?", "Lần cuối mình đi ăn chung là ở quán nào?".

Trong kỷ nguyên số 2025, "Tin nhưng phải kiểm chứng" (Trust but Verify) là kim chỉ nam để bảo vệ tài sản. Đừng để sự hoảng loạn nhất thời khiến bạn mất đi số tiền tích góp cả đời. Hãy chia sẻ bài viết này đến bố mẹ và người thân như một liều "vắc-xin" chống lừa đảo hiệu quả nhất.